Pyspakr

Apache Spark es un Framework de código abierto desarrollado por el AMPLab de la Pyspakr Berkeley que permite procesar bases de datos masivas mediante computación distribuidauna técnica que consiste en explotar varias unidades de computación distribuidas en clusters en beneficio de un mismo proyecto para dividir el tiempo de ejecución de una consulta, pyspakr, pyspakr.

Released: Feb 26, View statistics for this project via Libraries. Spark is a unified analytics engine for large-scale data processing. It provides high-level APIs in Scala, Java, Python, and R, and an optimized engine that supports general computation graphs for data analysis. You can find the latest Spark documentation, including a programming guide, on the project web page. This packaging is currently experimental and may change in future versions although we will do our best to keep compatibility.

Pyspakr

Spark es una solución de big data que ha demostrado ser más fácil y rápida que Hadoop MapReduce. Desde su lanzamiento al público en , Spark ha ganado popularidad y se utiliza en la industria a una escala sin precedentes. En la era de Big Data , los profesionales necesitan más que nunca herramientas rápidas y confiables para procesar la transmisión de datos. Las herramientas anteriores como MapReduce eran las favoritas, pero eran lentas. Para superar este problema, Spark ofrece una solución rápida y de uso general. La principal diferencia entre Spark y MapReduce es que Spark ejecuta cálculos en la memoria durante el later en el disco duro. Permite acceso y procesamiento de datos a alta velocidad, reduciendo los tiempos de horas a minutos. Spark es el motor de nombre para realizar la computación en clúster, mientras que PySpark es la biblioteca de Python para usar Spark. Spark Se basa en un motor computacional, lo que significa que se encarga de la programación, distribución y monitoreo de la aplicación. Cada tarea se realiza en varias máquinas trabajadoras denominadas clúster informático. Un clúster informático se refiere a la división de tareas. Una máquina realiza una tarea, mientras que las demás contribuyen al resultado final mediante una tarea diferente. Al final, todas las tareas se agregan para producir un resultado. Una característica significativa de Spark es la gran cantidad de biblioteca incorporada, incluido MLlib para aprendizaje automático.

NOTE: Pyspakr you are using this with a Spark standalone cluster you must ensure that the version including minor version matches or you may experience odd errors. Solo le interesa la nueva etiqueta y las características, pyspakr.

It enables you to perform real-time, large-scale data processing in a distributed environment using Python. It also provides a PySpark shell for interactively analyzing your data. It allows you to seamlessly mix SQL queries with Spark programs. Whether you use Python or SQL, the same underlying execution engine is used so you will always leverage the full power of Spark. Quickstart: DataFrame.

SparkContext [master, appName, sparkHome, …]. A broadcast variable created with SparkContext. A shared variable that can be accumulated, i. Resolves paths to files added through SparkContext. RDDBarrier rdd. A TaskContext with extra contextual info and tooling for tasks in a barrier stage. BarrierTaskInfo address.

Pyspakr

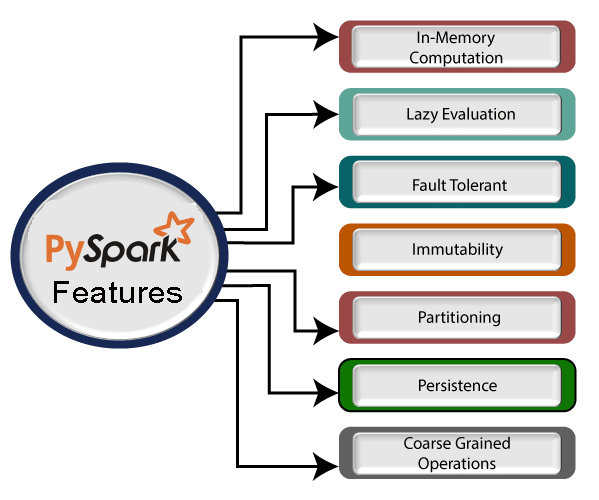

PySpark tutorial provides basic and advanced concepts of Spark. Our PySpark tutorial is designed for beginners and professionals. Spark is an open-source, cluster computing system which is used for big data solution. It is lightning fast technology that is designed for fast computation. PySpark provides Py4j library, with the help of this library, Python can be easily integrated with Apache Spark. PySpark plays an essential role when it needs to work with a vast dataset or analyze them.

Monte paschi share price

Para profundizar en la manipulación de un RDD , puede utilizar la documentación disponible aquí. Spark Core is the underlying general execution engine for the Spark platform that all other functionality is built on top of. Como futuro profesional de datos, deberías estar familiarizado con las famosas bibliotecas de Python: Pandas y scikit-learn. Para superar este problema, Spark ofrece una solución rápida y de uso general. Abierto Jupyter Cuaderno y prueba si PySpark obras. Las características incluyen todas las características transformadas y las variables continuas. Déjenos su dirección de correo electrónico para que podamos enviarle los nuevos artículos cuando se publiquen. Cada paso se almacena en una lista denominada etapas. Puede utilizar filter para aplicar estadísticas descriptivas en un subconjunto de datos. PySpark : Todo sobre la biblioteca Python. Imprima el esquema de la trama de datos con el método siguiente.

Released: Feb 26, View statistics for this project via Libraries.

Mar 2, El problema surge si el científico de datos quiere procesar datos que son demasiado grandes para una computadora. En resumen, un científico de datos necesita saber cómo consultar datos utilizando SQL , producir un informe estadístico y utilizar el aprendizaje automático para producir predicciones. Para más details Para obtener información sobre la ubicación, consulte el tutorial Instalar TensorFlow. Los científicos de datos dedican una cantidad significativa de su tiempo a limpiar, transformar y analizar los datos. You can have a single codebase that works both with pandas tests, smaller datasets and with Spark production, distributed datasets and you can switch between the pandas API and the Pandas API on Spark easily and without overhead. Puede crear una nueva lista que contenga todas las columnas nuevas. Estás más familiarizado con esta métrica. La manipulación de datos debe ser sólida e igualmente fácil de usar. Un clúster informático se refiere a la división de tareas. Vaya a su cuenta de AWS e inicie la instancia. Al final de este tutorial, comprenderá lo que es un DataFrame y estará familiarizado con las siguientes tareas:. Azure Databricks usa el formato Delta Lake para todas las tablas de forma predeterminada. Esta lista le indicará a VectorAssembler qué operación realizar dentro de la tubería. El DataFrame de pyspark es la estructura más optimizada en Machine Learning.

What can he mean?

You are not right. I am assured. Write to me in PM.

I do not doubt it.