Spark connector mongodb

Edycja bardzo dużych plików PDF w kilka sekund. Narzędzia i konwertery PDF. Szeroka gama narzędzi graficznych AI do naprawy i ulepszania zdjęć.

You can run this project locally, but Spark was designed to work with a lot of data and a big, distributed compute cluster so to unleash the full potential of this tool you may want to run it on a cloud. For example on Google Cloud Platform. Repository with an example project is available on my GitHub. The newest image is 2. You can see a list of available components version here. Because of that, you have to set specific versions of Java and dependencies in build.

Spark connector mongodb

Data Connectors Extract metadata from your data sources and build a single source of truth about your data. SQL Server Native. Oracle Native. Snowflake Native. PostgreSQL Native. Databricks Native. Tableau Native. Coming Soon. Qlik Sense Native. Microsoft Fabric Native. Analysis Services Tabular Native. Salesforce Native. MongoDB Native. MySQL Native.

Aby promować sprzedaż produktu, możesz sprzedawać produkt w ramach pakietu wraz z innymi powiązanymi produktami. The newest image is 2.

Przejdź na przeglądarkę Microsoft Edge, aby korzystać z najnowszych funkcji, aktualizacji zabezpieczeń i pomocy technicznej. W tym artykule przedstawiono rozwiązanie do uzyskiwania szczegółowych informacji z danych operacyjnych usługi MongoDB Atlas. Połączenie umożliwia transfer danych w partiach i w czasie rzeczywistym. Użycie tych znaków nie jest dorozumiane przez fundację Apache Software Foundation. Użycie tego znaku oznacza nie jest dorozumiane.

API Documentation. For issues with, questions about, or feedback for the MongoDB Kafka Connector, please look into our support channels. Please do not email any of the Kafka connector developers directly with issues or questions - you're more likely to get an answer on the MongoDB Community Forums. At a minimum, please include in your description the exact version of the driver that you are using. If you are having connectivity issues, it's often also useful to paste in the Kafka connector configuration. You should also check your application logs for any connectivity-related exceptions and post those as well. Want to see a new feature in the Kafka driver? Please open a case in our issue management tool, JIRA:. Skip to content.

Spark connector mongodb

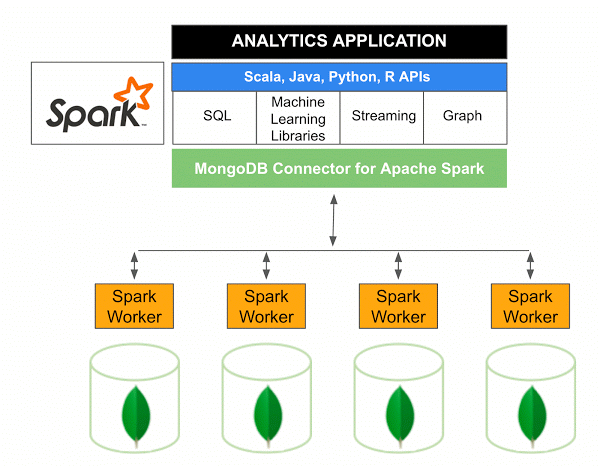

Its unique capabilities to store document-oriented data using the built-in sharding and replication features provide horizontal scalability as well as high availability. Spark provides a lower entry level to the world of distributed computing by offering an easier to use, faster, and in-memory framework than the MapReduce framework. Apache Spark is intended to be used with any distributed storage, e. In this article, I present the features of the connector and some use cases. An upcoming article will be a tutorial to demonstrate how to load data from MongoDB and run queries with Spark. The latest version - 2. The previous version - 1.

Spongebob gifs

Hybrid Data Lake. Dane w zdarzeniu zawierają nazwę pliku obiektu blob. Na przykład możesz wstrzymać dedykowane pule SQL, gdy nie oczekujesz żadnego obciążenia. Usługa MongoDB Atlas służy jako warstwa danych operacyjnych wielu aplikacji dla przedsiębiorstw. Synchronizacja w czasie rzeczywistym Przedsiębiorstwa potrzebują szczegółowych informacji opartych na danych w czasie rzeczywistym, a nie nieaktualnych danych. Dataflow is one of the service CSV Native. Informatica Big Data Management. Ten wyzwalacz subskrybuje temat usługi Event Grid publikowany przez aplikację internetową. Edytor prezentacji. Aby promować sprzedaż produktu, możesz polecić produkt klientom, którzy są zainteresowani powiązanymi produktami.

Build with MongoDB Atlas.

Jakub Prądzyński's Blog. This post is licensed under CC BY 4. Brak umów do anulowania. Wynikowe przepływy danych można uruchamiać jako działania w potokach usługi Azure Synapse Analytics, które używają skalowanych w poziomie klastrów platformy Apache Spark. Azure Synapse Analytics to podstawowa usługa używana przez to rozwiązanie do pozyskiwania, przetwarzania i analizy danych. All those steps are available in the single shell script, which you can check here. Usługa Data Lake Storage zapewnia możliwości przechowywania i przetwarzania danych. Analiza przedstawia dwie sugestie dotyczące uzyskania lepszej sprzedaży: Łączenie długopisu i tuszu do ponownego wypełniania Promowanie pakietu w niektórych obszarach Promocja produktu Aby promować sprzedaż produktu, możesz polecić produkt klientom, którzy są zainteresowani powiązanymi produktami. Informatica Data Lake Management. Następne kroki Aby uzyskać więcej informacji na temat rozwiązania, skontaktuj się z. Redash Native.

0 thoughts on “Spark connector mongodb”